AIを介してアップデートするコミュニケーション

――東京大学大学院准教授 馬場雪乃氏に聞く(2)

AIとのパートナーシップをデザインすることで、これまで困難だった人と人とのコミュニケーションを導くことができる。馬場雪乃氏へのインタビュー第2回では、高校生1年生を対象に行なった実証実験をはじめ、示唆に富んだ事例がいくつも紹介された。

2024年5月23日 東京大学馬場雪乃研究室にて

|

馬場 雪乃(ばば ゆきの) 東京大学大学院総合文化研究科広域科学専攻准教授。東京大学大学院情報理工学系研究科創造情報学専攻博士課程修了。情報理工学博士(東京大学)。国立情報学研究所特任研究員、京都大学大学院情報学研究科助教、筑波大学システム情報系准教授などを経て2022年より現職。人工知能学会理事・代議員。人工知能、人とAIの協働、集合知、クラウドソーシングの研究に従事。人間の正確な判断をAIに取り入れる機械学習技術を多数開発。JSTムーンショット型研究開発プロジェクトにおいて、人間と協働して研究を行うパートナーAIの開発を推進する。2024年IPSJ/IEEE Computer Society Young Computer Researcher Award受賞。共著書に『データサイエンティスト養成読本 機械学習入門編』(技術評論社)『ヒューマンコンピュテーションとクラウドソーシング』(講談社)がある。

|

目次

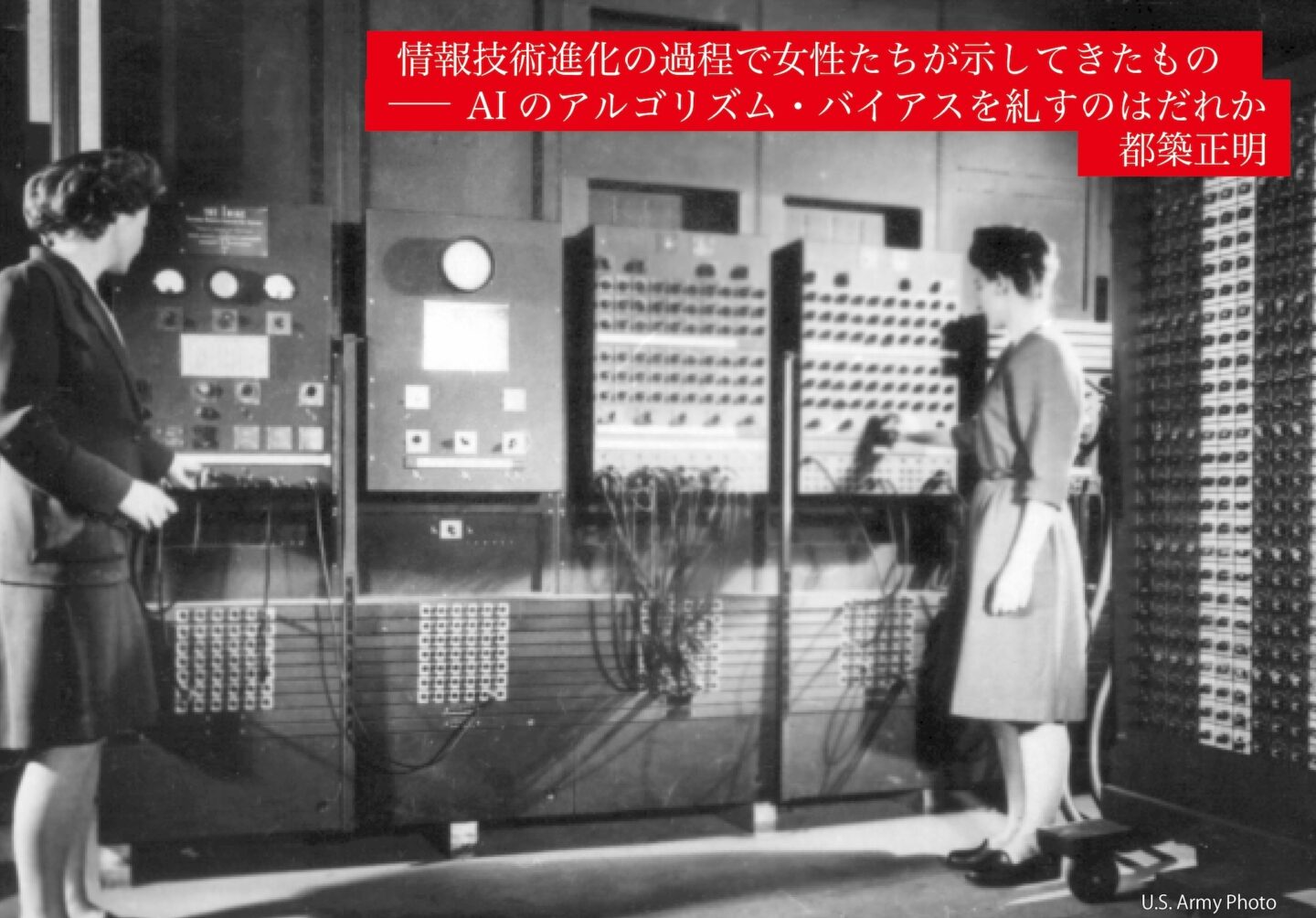

AIからの順伝播による人のバイアスクレンジング

都築正明(以下――) 今年発表された、機械学習を用いてバイアスクレンジングを行うツールについて教えてください。

馬場雪乃氏(以下、馬場) たとえば日本人のアパートのオーナーが黒人の方には家を貸したがらないというように、人が人物評価をする際には人種や性別にかんしてバイアスがかかってしまいます。私たち研究者が予算申請書の評価をするときにもダイバーシティに配慮するよういわれますが、どのように判断基準を調整したらよいのか、わかりづらいという現状があります。そこで、人の判断をどのように変えれば公正になるのかをAIが教えてあげるツールを開発しました。

――AIの内部にバイアスがあったり、私たちのバイアスをAIが可視化したりすることがよくいわれますが、それを人間にフィードバックすることで、どうすればよいかを示唆してくれるということでしょうか。

馬場 はい。たしかにAIの内部にはバイアスがありますが、モデルに少し手を加えることで、人間よりもずっと簡単にバイアスを減らすことができます。このようにAIのバイアスを減らすことで、教師として人間の判断を助けてあげるスキームになっています。

――昨年、GoogleやX(旧Twitter)でアルゴリズム・バイアスを指摘した研究者が解雇される事案が相次ぎましたが、そうした構図を変えられる技術でもありますね。

馬場 ツールをつくるにあたっては、そうした状況が改善することを期待していました。ただし、人が意思決定をするかぎり、このツールを実用化することで、すぐに人々のバイアスが減るというわけにはいきません。

――先生は、集団の選好に基づいた意思決定を支援するCrowDEAというツールも開発されていますよね。

馬場 開発にあたって考えていたのは、たとえば団体やイベントのキャラクターデザインを決めるにあたって100個や1000個とたくさんのアイデアが出てきたような状況です。一般的には多数決で決めたり、投票のうえで得票数上位の数案に絞って議論して決めたりします。そうすると多数派がよいと思うものだけが最終的な候補に残ってしまい、もとの100個や1000個のアイデアのなかにあった多様性が失われてしまうということに疑問を持ちました。私たちが開発したCrowDEAでは、投票するまでは同じですが、意見集約にあたっては単純な多数決ではなく、推定した異なる価値観に応じたものを選ぶことができます。たとえばAという価値観とBという異なる価値観があった場合には、Aの価値観で最良のものと、Bの価値観で最良のものを提示するわけです。ですから、特定の多数派だけがよいと思うものでなく、価値観のばらつきに配慮したうえでよいと思うものを選ぶことができます。

――大規模なイベントのキャラクター選びでは、自分がよいものではなく、みんながよいと思うであろう最大公約数的なものに投票して、つまらないものばかりが残ってしまうことがあります。その結果、つまらない最終候補のなかからマシだと思うものを選ぶことになってしまったり。

馬場 そうですね。

桐原永叔(以下、桐原) ケインズのいう美人投票のようですね。株式には、みんなが上がると思うものが上がるという自己言及性がありますよね。ChatGPTが自己言及的に意見を生成してしまうともっとらしいだけのアウトプットが人々の総意となって、個々の価値観が均されてしまう可能性もありますよね。

馬場 おっしゃる通り、私たちの価値観が汚染されていくことが心配です。私たちは、どうしても楽なほうに流されていきますから。耳障りがよくて、もっともらしいことをGPT-4が言ってくれると、それでよしとしてしまう。 そこで考えることをやめてしまう傾向は、今後より進んでいくことが危惧されます。

桐原 考えたり悩んだりすることが好きな人は多くないですし、ほかの人がどう思うのかを気にしてしまう。

馬場 まったくその通りですね。選択肢を提示されると、みんながどう言っているのかを気にしてしまう。キャラクターデザインの場合は多くの人に気に入られることも重要ですから最大公約数的なものを選ぶのも仕方ないと思いますが、1人で外食するときに、自分が食べたいものではなく、SNSで多くの「いいね」がもらえるものを選ぶような傾向は、今後どんどん進んでくのではないかと思います。

少数派の価値ある意見を生かした議論をみちびくAI

――価値交換工学の研究で高校生を対象にされた実証実験が興味深かったです。

馬場 高校1年生のクラスで行った実験です。クラス全体の困りごととして、みんなでプレゼンしたりレポートを作成したりするグループワークに、積極的に取り組まない人がいるということが挙げられたので、その解決策を話し合ってもらいました。そこではクラスを半分に分けて、一方は生徒だけで、他方はAIを交えて話し合ってもらいました。生徒だけで話し合うと、熱心に取り組む人たちのほうが意見が出しやすく、いかに取り組まない人を課題に取り組ませるかという“上から目線”の議論になり、取り組まない人が口を出せる雰囲気ではなくなってしまいました。話し合いの結果も、取り組まない人に課題を割り当てて、逃げられないような役割分担にしたり、その人が課題をしなければ全員が困る状況をつくってしまうような結論に至りました。これは課題に積極的に取り組む人にとって都合のよい結論ですよね。

――AIを交えて話し合うにあたっては、AIはどのような役割を担ったのでしょう。

馬場 私たちの開発したアプリを用いて、事前にクラスの生徒たちから意見を集めました。このアプリは、集まった意見を自動で整理して、大分類・中分類というようにカテゴライズします。生徒たちの議論にあたっては、この分類をもとに話し合ってもらいました。

――その結果、話し合いのプロセスや結論には大きな変化はあったのでしょうか。

馬場 話の流れをつくるうえでは、コミュニケーションという項目がカテゴリーに上がってきたのが大きかったです。まずコミュニケーションが議題になり得ることが共有されましたし、課題に取り組まない人にも理由があるという観点に立った議論にもなりました。ツールをつかったことで、取り組まない人は嫌だからしないのではなくて自信がないからしない、というような声も発見されるようになり、分断があるのはコミュニケーションの問題だということが論点化されて、問題を解決するためには、なんでも言い合えることが大切だという議論に発展しました。AIを交えたグループの結論は、グループ内できちんと言いたいことを言える環境をつくり、発言内容とその人とをしっかり切り離すことが必要だというものでした。高校1年生がそこにたどりついてくれたことに、感動しましたよ。

――双方の立場を尊重して上位の結論を導き出す、理想的な議論ですね。

馬場 挙がってきた意見にも“心理的安全性”という言葉がつかわれていたりして驚きました。

――それまで発言できなかった生徒も、自分の認知をメタ化できているわけですね。

桐原 顔色をみて話せない人に意見を求めたり、意見だけ聞く場を設けたりというのは、優秀なファシリテーターがするようなことですね。

馬場 こうした話し合いで高校生がファシリテーターを務めると、順番に話を聞いていくことは難しいですよね。ファシリテーターを担当する高校生自身の思惑も入ってしまうと思いますし。客観的にファシリテートするのはかなり難しいスキルですから、そこをAIが助けてあげたといえます。

――教師がファシリテートをしてしまうとまた難しいですよね。

馬場 教師にも思惑があるでしょうし、素直な意見が出づらくなって、教師に気に入られる意見が優先されそうな気がします。

――高校生に限らず、企業でブレインストーミングが成立しないことも多くあります。みんなが上司の気に入りそうな意見を言いがちだという。

馬場 最終的には責任者が決めるので仕方がないところもありますが、多様な意見を募る意味では、もったいないですね。

多様な価値観のもとで足し算ではない集合知を実現する

――カナダで発表(Educational Data Mining 2019)された、ピア・ラーニングやピア評価の研究についてもお聞かせください。

馬場 評価においては、まず評価者にその資質があることが重要です。私たちの研究では、評価者の信頼性も加味したうえで評価の集約をする技術を開発して、その問題解決をはかることを目指しました。評価をするというのは、とても難しいスキルですが、私たちは専門的なレクチャーも受けないままに評価をしているのが現状だと思います。これからは、人からよりよい評価を引き出すための技術をつくっていけるとよいですね。評価を細分化することも考えられますし、ある人への評価がほかの人の評価と矛盾していることを指摘してAI側から見直しを要求することでサポートするツールなどがつくれたらよいと思います。

――学校教育では、教育評価というのは教育学では教育心理の1分野にすぎません。学習指導要領で観点を少し変えることはあっても、源流は40年以上前のメソッドに基づいていたりします。しかもそれが共有されないままになっていて、結局は経験とコツとカンだよ、となってしまう。

馬場 先ほどの研究者のサポートの話もそうですが、カンやコツですまされている部分を客観的なものにしていかないと、カンやコツの伝承も進みません。また評価される側からしても、どのような基準で評価されているのかという透明性がなければ納得できないでしょうし、修正のしようもありません。

――学びということで考えると、GIGAスクール構想以降、個々のミクロな学びについてはAIがフォローする兆しがみえています。一方「主体的で対話的な深い学び」を掲げつつもグループワークやアクティブ・ラーニングについては定量的な観点が出てきていない気がします。

馬場 そこには、何人かをグループにまとめておきさえすれば相互作用が自然発生してよい学びができるのではないかという短絡的な発想がありますね。アクティブ・ラーニングやグループワークには、かなりのノウハウが必要ですが、教育現場ではノウハウのレクチャーを受けないままに、とりあえず形だけ整えているのかもしれないですね。さきほどの意見集約の研究は価値交換工学のなかで行ったものですが、このプロジェクトでは、さまざまな分野の研究者がそれぞれの観点から価値交換というテーマを捉えて研究をすすめています。私は、人によって価値観が違うという点に着目して、それぞれの価値観を尊重するための技術をつくっています。

――先生の開発されたSwipeGANSpaceも多様な人々にひらかれたツールだと思いました。コマンドラインをGUIにしたように、プロンプトを視覚的に操作できるようにしたイメージです。

馬場 たとえば弁護士AIのアバターをつくるときに、ふつうはテキストでプロンプトを書いて画像を生成しますが、なかなか思ったようなものが出てこないので、プロンプトを調整します。しかし人によってはテキストをいろいろと考えるのは難しい作業です。このアプリはマッチングアプリのようなインターフェースになっていて、最初に候補の画像が1つ出てきて、それがイメージと合っていたら右にスワイプ、合っていなかったら左にスワイプします。スワイプするたびにAIが次の候補になる画像を推定して生成しますから、操作としてはイメージに合った画像が生成されるまでスワイプを繰り返すだけです。

――考えてみれば、画像をつくるのにテキストを弄するのは迂遠な作業にも思えます。

馬場 このツールの開発は、言語化しなくても自分の発想をAIが形にしてくれればよいのではないかという発想のもとではじめました。人物画像生成のツールではありますが、私たちがテキストベースのコミュニケーションに依存しているなかで、言語化が苦手な人が不利な環境になっているのではないかという、さきほど紹介した論点を整理するAIと同じ懸念にもとづいて着想したものです。

――「言語化」というワードが、意味や心情を言葉にするというよりも、言葉をつかってビジネスや人間関係を円滑にするスキルのような含意で使われることが多くなっています。

馬場 たしかにそうですね。コミュニケーションスキルやプレゼンスキルと同じような使われ方をしています。その能力が高くないとAIを使いこなすことができないのは本末転倒な気もします。

人とAIとの関係と、人と人との関係

――ヒューマン・イン・ザ・ループ(Human-in-the-Loop)の研究では、GAN(Generative adversarial networks:敵対的生成ネットワーク)に人を介在させるシステムも開発されていますよね。

馬場 HumanGANとHumanACGANですね。GANは画像の生成などに用いられるモデルで、内部的には画像を生成する生成器(Generator)と、その画像が本物かどうかをこう識別する識別器(Discriminator)の2者がせめぎ合いながら生成能力を鍛えていきます。この方式では、データ空間の中でよりよい生成モデルを探索するだけになってしまいますので、そこに人の知見を入れるようにしました。識別器が自然だと判断するレベルと人が自然だと判断するレベルとは異なりますから、人がどういう画像を自然だと感じるのかという知覚を入れてあげたほうがよいだろうと考え、生成器と戦わせる識別器を人に置き換える技術になっています。

――そうすると、生成器が人間と戦う構図になるわけですね。

馬場 そうです。人間が騙されるほどのものができれば、そこがゴールになります。私たちがこれを開発したのは2020年で、人の発話を対象に実験を行いました。先日リリースされたGPT-4oでは、こうしたツールを用いずに自然な音声をつくるところまできています。やはり生成AIにおいてはデータ量がものをいうことですね。

――このノウハウを生かせば、聴覚のほかにもサポートすることができるわけですよね。

馬場 そうです。ChatGPTでは自然言語処理においてはRLHF(Reinforcement Learning from Human Feedback:人間からのフィードバックを用いた強化学習)というテクノロジーを用いて、GPTからの出力を見せながら人間が好むものにチューニングしていますが、発想としてはHumanGANと同じです。

――クラウドソーシングでは、低単価でプログラムや記事の作成を依頼することも多くありますが、今後は心理的負担の大きな作業を委託することも懸念されます。OpenAIが不適切なコンテンツのモデュレーションを2ドル以下の時給でケニアに発注していた事例もありますし、Metaは社内のコンテンツ・モデュレーターが深刻なPTSDや抑うつ症状に苦しんでいることが報じられて行政指導を受けると、アクセンチュアに外注するようになりました。クラウドワーカーにそうした仕事を依頼することで、責任を希薄化することは十分考えられます。

馬場 AIはそうしたクラウドワーカーの力を使って賢くなっていきます。AIがここまで世の中に浸透すると、AIの性能が向上する利益を享受する人たちはとても多いわけです。すると、大多数の利益にたいして少数の人が負担を強いられるのは、税金のようなもので仕方がないという発想になりかねません。私はそれを、かなり恐ろしい考えだと思います。

――かつてテッド・チャンが「AIにはブルシット・ジョブをさせておけばよい」と言っていましたが、正反対のことが起こり得るということですね。むしろAIを支えるために人間がブルシット・ジョブを負わなければならない。

馬場 そうですね。ちょっと不愉快な画像の判別などは、もう全ユーザーで行ったほうがよいかと思います。AIをよくするためのブルシット・ジョブはAIユーザーで平等に分散させて、コストを均等に配分する。

――「私はロボットではありません」というチェックをするreCAPTCHAで、OCRで読めないテキストの学習や画像のタグづけに貢献することに近いですね。

馬場 そうですね。書籍の電子化のメリットを享受するためのお手伝いをするように、記事を読みたかったりWebサービスをつかったりしたければ、少し嫌な画像をみてもらうようなことがあってもよいと思います。できるだけ人々の幸福を損なわずに、AIの支えになる膨大なゴーストワークを人に任せていく方法については、社会的にきちんと考えなければならないと思います。